RÔ BỐT CÓ CẢM XÚC/TÌNH CẢM

Gặp Nao.

Khi anh ấy hạnh phúc, anh ấy sẽ dang tay ra để chào bạn, muốn một cái ôm nồng nàn. Khi anh buồn, anh gục đầu xuống và xuất hiện bằng vẻ mặt buồn thiu, với đôi vai gục về phía trước. Khi anh ta hốt hoảng, anh ta co rúm lại trong sợ hãi, cho đến khi ai đó vỗ vào đầu anh ta trấn an.

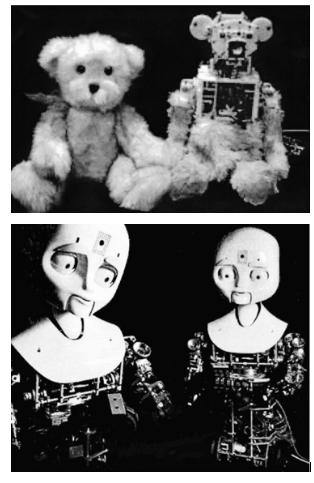

Anh ta chỉ như một cậu bé một tuổi, ngoại trừ việc anh ta là một robot. Nao cao khoảng một mét rưỡi, và trông rất giống một số robot bạn thấy trong cửa hàng đồ chơi, như Tranformers (Robot biến hình), ngoại trừ việc anh ta là một trong những robot tình cảm tiên tiến nhất trên trái đất. Anh được chế tác bởi các nhà khoa học tại Đại học Hertfordshire của Vương quốc Anh, nơi nghiên cứu được tài trợ bởi Liên minh châu Âu.

Những người sáng tạo của anh ấy đã lập trình cho anh ấy thể hiện những cảm xúc như hạnh phúc, buồn, sợ hãi, phấn khích và tự hào. Trong khi các robot khác có cử chỉ thô sơ trên khuôn mặt và lời nói truyền đạt cảm xúc của chúng, thì Nao lại nổi trội về ngôn ngữ cơ thể, như tư thế và cử chỉ. Nao thậm chí còn khiêu vũ.

Không giống như các robot khác, chuyên làm chủ chỉ một trong những cảm xúc, Nao đã thành thạo một loạt các phản ứng cảm xúc. Đầu tiên, Nao khóa (sự quan sát) vào khuôn mặt của khách thăm viếng, xác định chúng và ghi nhớ các tương tác trước đây của anh ta với từng người trong số họ. Thứ hai, anh bắt đầu theo dõi các chuyển động của họ. Ví dụ, anh ta có thể theo dõi ánh mắt của họ và nói về những gì họ đang nhìn. Thứ ba, anh bắt đầu gắn kết với họ và học cách đáp lại cử chỉ của họ. Ví dụ, nếu bạn cười với anh ấy, hoặc vỗ nhẹ vào đầu anh ấy, anh ấy biết rằng đây là một dấu hiệu tích cực. Bởi vì bộ não của anh ta có mạng lưới thần kinh (được thiết kế với nguyên lý giống như), anh ta học được từ các tương tác với con người. Thứ tư, Nao thể hiện cảm xúc để đáp lại sự tương tác của anh ấy với mọi người. (Phản ứng cảm xúc của anh ấy đều được lập trình sẵn, giống như một máy ghi âm, nhưng anh ấy quyết định nên chọn cảm xúc nào để phù hợp với tình huống.) Và cuối cùng, Nao càng tương tác với một con người, anh ta càng hiểu được tâm trạng của người đó và mối liên kết càng trở nên mạnh mẽ.

Nao không chỉ có một tính cách, anh ấy thực sự có thể có một vài trong số chúng. Bởi vì anh ta học được từ các tương tác của mình với con người và mỗi tương tác là đặc trưng duy nhất, cuối cùng các tính cách khác nhau bắt đầu xuất hiện. Ví dụ, một tính cách có thể khá độc lập, không đòi hỏi nhiều hướng dẫn của con người. Một tính cách khác có thể là rụt rè và sợ hãi, hoảng hốt bởi các đồ vật trong phòng, liên tục cần sự can thiệp của con người.

Người lãnh đạo dự án cho Nao là Tiến sĩ Lola Canamero, một nhà khoa học máy tính tại Đại học Hertfordshire. Để bắt đầu dự án đầy tham vọng này, cô đã phân tích các tương tác của tinh tinh. Mục tiêu của cô là tái tạo, càng gần càng tốt, hành vi tình cảm của một con tinh tinh một tuổi.

Cô thấy các ứng dụng ngay lập tức cho những robot cảm xúc này. Giống như bác sĩ Breazeal, cô muốn sử dụng những robot này để làm giảm sự lo lắng của trẻ nhỏ đang ở trong bệnh viện. Cô nói: "Chúng tôi muốn khám phá các vai trò khác nhau – các robot sẽ giúp trẻ hiểu được cách đối xử của chúng, giải thích những gì chúng phải làm. Chúng tôi muốn giúp các em kiểm soát sự lo lắng của các bạn."

Một khả năng khác là các robot sẽ trở thành bạn đồng hành tại các viện dưỡng lão. Nao có thể trở thành một bổ sung có giá trị cho các nhân viên của một bệnh viện. Tại một số điểm, những robot như thế này có thể trở thành bạn chơi đùa với trẻ em và là một phần của gia đình.

"Thật khó để dự đoán tương lai, nhưng sẽ không quá lâu trước khi máy tính trước mặt bạn sẽ là một robot xã hội. Bạn sẽ có thể nói chuyện với nó, tán tỉnh nó, hoặc thậm chí tức giận và la hét vào nó – và nó sẽ hiểu bạn và cảm xúc của bạn", Tiến sĩ Terrence Sejnowski thuộc Viện Salk, gần San Diego nói. Đây là phần dễ dàng. Phần khó là để đánh giá phản ứng của robot, ví như đưa ra thông tin như này. Nếu chủ sở hữu tức giận hoặc không hài lòng, robot phải có khả năng đưa yếu tố này vào phản ứng của nó.

CẢM XÚC: XÁC ĐỊNH ĐIỀU GÌ LÀ QUAN TRỌNG

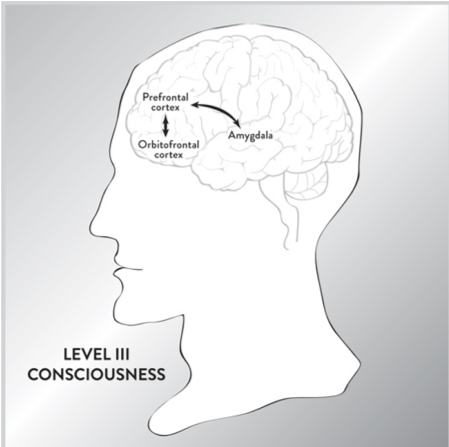

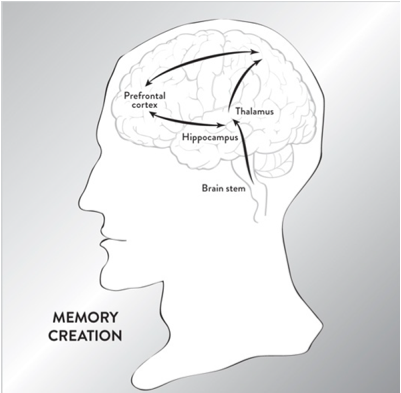

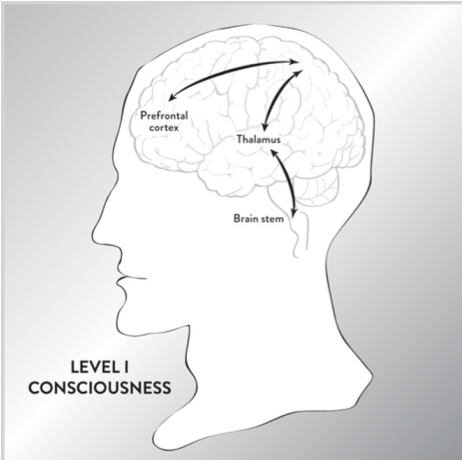

Hơn nữa, các nhà nghiên cứu AI đã bắt đầu nhận ra rằng cảm xúc (emotions) có thể là chìa khóa cho ý thức (consciousness). Các nhà thần kinh học như Tiến sĩ Antonio Damasio đã phát hiện ra rằng khi liên kết giữa thùy trước trán (chi phối suy nghĩ hợp lý) và các trung tâm cảm xúc (ví dụ, hệ thống limbic) bị tổn thương, (hệ quả là) bệnh nhân không thể đưa ra đánh giá hay phán đoán giá trị (value judgments). Họ bị tê liệt khi đưa ra quyết định đơn giản nhất (nên mua gì, khi nào nên đặt cuộc hẹn, sử dụng bút màu nào) vì mọi thứ đều có cùng giá trị với họ. Do đó, các cảm xúc không phải là một thứ xa xỉ; chúng thực sự cần thiết và không có chúng, robot sẽ gặp khó khăn trong việc xác định cái gì là quan trọng và cái gì không. Vì vậy, cảm xúc, thay vì là thực thể ngoại vi (being peripheral) đối với sự tiến bộ của trí tuệ nhân tạo, giờ đây đang đảm nhận tầm quan trọng trung tâm.

Nếu robot gặp phải một đám cháy dữ dội, nó có thể giải cứu các tệp tin trong máy tính trước tiên, chứ không phải con người, vì chương trình của nó có thể nói rằng các tài liệu có giá trị không thể thay thế nhưng công nhân luôn có thể. Điều quan trọng là robot phải được lập trình để phân biệt giữa điều gì là quan trọng và điều gì không, và cảm xúc là lối tắt mà não sử dụng để nhanh chóng xác định điều này. Do đó, robot phải được lập trình để có một hệ thống giá trị - rằng cuộc sống của con người quan trọng hơn các vật thể, rằng trẻ em cần được giải cứu trước trong trường hợp khẩn cấp, rằng các vật thể có giá cao hơn có giá trị hơn các vật thể có giá thấp hơn, v.v. Vì robot không được trang bị (lập trình hay có sẵn) các (khái niệm về) giá trị, nên một danh sách lớn các đánh giá về giá trị (value judments) phải được tải lên.

Tuy nhiên, vấn đề với cảm xúc là đôi khi chúng không hợp lý, trong khi robot chính xác về mặt toán học. Vì vậy, [ý thức silicon] có thể khác với [ý thức của con người] theo những cách chính yếu. Ví dụ, con người ít kiểm soát cảm xúc, vì chúng xảy ra quá nhanh và vì chúng bắt nguồn từ hệ thống limbic chứ không phải vỏ não trước trán. Hơn nữa, cảm xúc của chúng ta thường bị thiên vị/thiên kiến/biased. Nhiều thử nghiệm đã chỉ ra rằng chúng ta có xu hướng đánh giá cao khả năng của những người đẹp trai xinh gái hơn. Những người đẹp trai xinh gái có xu hướng vươn lên cao hơn trong xã hội và có công việc tốt hơn, mặc dù họ có thể không tài giỏi như những người khác. Theo cách diễn đạt, "Vẻ đẹp có những đặc quyền của nó – Beauty has its privileges."

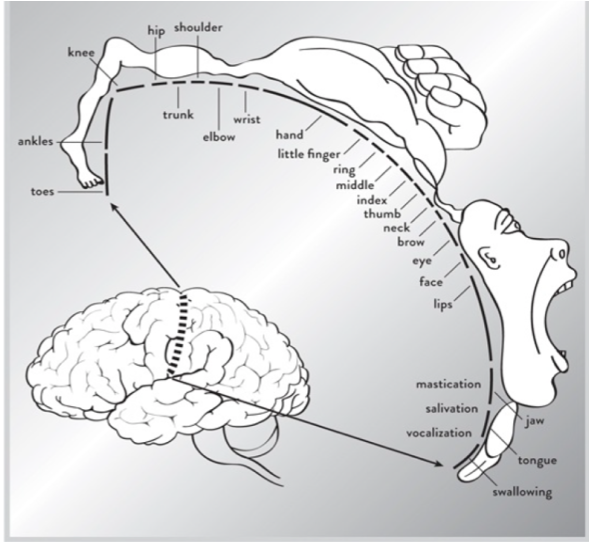

Tương tự, ý thức silicon có thể không tính đến các tín hiệu tinh tế mà con người sử dụng khi gặp nhau, như ngôn ngữ cơ thể. Khi mọi người vào phòng, những người trẻ tuổi vào phòng, người nhỏ tuổi hơn thường kính trọng hay nhường chỗ cho những người lớn tuổi hơn và các nhân viên cấp thấp thể hiện sự lịch sự đặc biệt đối với các quan chức cấp cao. Chúng ta thể hiện sự kính trọng trong cách chúng ta di chuyển cơ thể, lựa chọn từ ngữ và cử chỉ của chúng ta. Bởi vì ngôn ngữ cơ thể thì cổ xưa hơn chính bản thân ngôn ngữ của chúng ta, nó được gắn hay ghi chặt vào bộ não theo những cách tinh tế. Robot, nếu chúng muốn tương tác xã hội với con người, chúng sẽ phải học những tín hiệu vô thức này.

Ý thức của chúng ta bị ảnh hưởng bởi những đặc thù trong quá khứ tiến hóa của chúng ta, điều mà robot sẽ không có, vì vậy [ý thức silicon] có thể không có những khoảng trống hoặc sự kỳ quặc như chúng ta.

MỘT DANH MỤC ĐỂ CHỌN LỰA CẢM XÚC

Vì cảm xúc phải được lập trình thành robot từ bên ngoài, các nhà sản xuất có thể đưa ra một danh mục cảm xúc được lựa chọn cẩn thận trên cơ sở rằng liệu chúng có cần thiết, hữu ích hay sẽ tăng liên kết với chủ sở hữu.

Trong tất cả khả năng, robot sẽ được lập trình để chỉ có một vài cảm xúc của con người, tùy thuộc vào tình huống. Có lẽ cảm xúc được đánh giá cao nhất bởi chủ sở hữu của robot sẽ là lòng trung thành. Người ta muốn một robot trung thành thực hiện các mệnh lệnh của mình mà không phàn nàn, hiểu được nhu cầu của chủ và dự đoán chúng. Điều cuối cùng mà chủ sở hữu sẽ muốn là một robot có thái độ, một robot (có khả năng) nói lại, phản biện mọi người và biết than vãn. Những lời phản biện hữu ích rất quan trọng, nhưng chúng phải được thực hiện một cách xây dựng, khéo léo. Ngoài ra, nếu con người đưa ra các lệnh xung đột, robot có thể sẽ nên biết bỏ qua tất cả chúng trừ những thứ đến từ chủ nhân của nó.

Đồng cảm (Empathy) sẽ là một cảm xúc khác sẽ được chủ sở hữu đánh giá cao. Robot có sự đồng cảm sẽ hiểu vấn đề của người khác và sẽ đến trợ giúp họ. Bằng cách (phân tích) diễn giải sự vận động của khuôn mặt và lắng nghe giọng nói, robot sẽ có thể xác định khi một người gặp nạn và sẽ cung cấp sự hỗ trợ khi có thể.

Kỳ lạ thay, sợ hãi (fear) là một cảm xúc khác, là thứ mong muốn. Sự tiến hóa đã cho chúng ta cảm giác sợ hãi vì một lý do, để tránh những điều nguy hiểm nhất định đối với chúng ta. Mặc dù robot sẽ được làm bằng thép, nhưng chúng nên sợ một số thứ có thể làm hỏng chúng, như rơi khỏi các tòa nhà cao tầng hoặc xông vào một đám cháy dữ dội. Một robot hoàn toàn không sợ hãi là một sản phẩm vô dụng nếu nó tự hủy diệt.

Nhưng một số cảm xúc nhất định có thể phải bị xóa, bị cấm hoặc điều chỉnh ở mức cảnh báo cao, chẳng hạn như sự tức giận (anger). Cho rằng robot có thể được chế tạo để có sức mạnh thể chất tuyệt vời, và robot giận dữ có thể tạo ra những vấn đề nghiêm trọng trong nhà và nơi làm việc. Sự tức giận có thể cản trở nhiệm vụ của nó và gây ra thiệt hại lớn cho tài sản. (Mục đích tiến hóa ban đầu của sự tức giận là thể hiện sự không hài lòng của chúng ta. Điều này có thể được thực hiện một cách hợp lý, theo cách tránh bị phát cuồng lên, không trở nên tức giận.)

Một cảm xúc khác nên được xóa là mong muốn được chỉ huy. Một robot hống hách sẽ chỉ gây rắc rối và có thể thách thức sự phân định và mong muốn của chủ sở hữu. (Điểm này cũng sẽ quan trọng sau này, khi chúng ta thảo luận về việc liệu một ngày nào đó robot sẽ tiếp quản con người.) Do đó, robot sẽ phải trì hoãn lại và hướng về mong muốn của chủ sở hữu, ngay cả khi đây có thể không phải là con đường tốt nhất.

Nhưng có lẽ cảm xúc khó truyền tải nhất là sự hài hước, đó là chất keo có thể gắn kết toàn bộ người lạ với nhau. Một trò đùa đơn giản có thể xoa dịu một tình huống căng thẳng hoặc gây ra nó. Các cơ chế cơ bản của sự hài hước rất đơn giản: chúng liên quan đến một loạt những bất ngờ (punch line) không lường trước được. Nhưng sự tinh tế của sự hài hước có thể là rất lớn. Trên thực tế, chúng ta thường tăng kích thước người khác trên cơ sở cách họ phản ứng với những trò đùa nhất định. Nếu con người sử dụng sự hài hước như một thước đo để đo lường người khác, thì người ta có thể đánh giá cao sự khó khăn trong việc tạo ra một robot có thể biết được một trò đùa có hài hước hay không. Tổng thống Ronald Reagan, chẳng hạn, nổi tiếng vì đã thách thức những câu hỏi khó nhất với một câu trả lời lại đầy châm biếm. Trong thực tế, ông ta đã tích lũy một danh mục lớn gồm những câu chuyện cười, sắc xảo và khôn ngoan, bởi vì ông ta hiểu được sức mạnh của sự hài hước. (Một số chuyên gia kết luận rằng ông đã giành chiến thắng trong cuộc tranh luận tổng thống chống lại Walter Mondale khi ông được hỏi liệu ông có quá già để trở thành tổng thống hay không. Reagan trả lời rằng ông ta sẽ không giữ được tuổi trẻ của đối thủ chống lại anh ta.) Ngoài ra, cười không đúng cách có thể gây ra hậu quả tai hại (và trên thực tế, đôi khi là dấu hiệu của bệnh tâm thần). Robot phải biết sự khác biệt giữa cười với hoặc với ai đó. (Các diễn viên nhận thức rõ về bản chất đa dạng của tiếng cười. Họ là những người tài giỏi để tạo ra tiếng cười, thứ có thể đại diện cho nỗi kinh hoàng, sự hoài nghi, niềm vui, sự tức giận, nỗi buồn, v.v ... Vì vậy, ít nhất cho đến khi lý thuyết về trí thông minh nhân tạo trở nên phát triển hơn, robot nên tránh xa sự hài hước và tiếng cười.

VIỆC LẬP TRÌNH CẢM XÚC – PROGRAMMING EMOTIONS

Trong cuộc thảo luận này, cho đến nay chúng ta đã lảng tránh câu hỏi khó về việc chính xác những cảm xúc này sẽ được lập trình vào máy tính như thế nào. Vì sự phức tạp của chúng, cảm xúc có thể sẽ phải được lập trình theo từng giai đoạn.

Đầu tiên, phần dễ nhất là xác định cảm xúc bằng cách phân tích cử chỉ trên khuôn mặt, môi, lông mày và giọng nói của một người. Công nghệ nhận dạng khuôn mặt ngày nay đã có khả năng tạo ra một từ điển cảm xúc, do đó, một số biểu hiện trên khuôn mặt có ý nghĩa nhất định cụ thể nào đó. Quá trình này thực sự quay trở lại với Charles Darwin, người đã dành một lượng thời gian đáng kể để phân loại các cảm xúc phổ biến cho động vật và con người.

Thứ hai, robot phải đáp ứng nhanh chóng với cảm xúc này. Điều này cũng dễ dàng. Nếu ai đó đang cười, robot sẽ toe toét theo. Nếu ai đó tức giận, robot sẽ tránh đường và né sự xung đột. Robot sẽ có một bộ bách khoa toàn thư về cảm xúc được lập trình trong đó, và do đó sẽ biết cách tạo ra phản ứng nhanh chóng cho từng trường hợp một.

Giai đoạn thứ ba có lẽ là phức tạp nhất vì nó liên quan đến việc cố gắng xác định động lực hay nguồn cơn cơ bản ẩn đằng sau cảm xúc ban đầu kia. Điều này là khó khăn, vì một loạt các tình huống có thể kích hoạt một cảm xúc duy nhất. Tiếng cười có thể có nghĩa là ai đó đang hạnh phúc, nghe một trò đùa hoặc nhìn ai đó ngã. Hoặc nó có thể có nghĩa là một người lo lắng, lo lắng hoặc xúc phạm ai đó. Tương tự như vậy, nếu ai đó đang la hét, có thể có trường hợp khẩn cấp, hoặc có lẽ ai đó chỉ đang phản ứng với niềm vui và bất ngờ. Xác định lý do đằng sau một cảm xúc là một kỹ năng mà ngay cả con người cũng gặp khó khăn. Để làm điều này, robot sẽ phải liệt kê các lý do khác nhau có thể đằng sau một cảm xúc và cố gắng xác định lý do có ý nghĩa nhất. Điều này có nghĩa là cố gắng tìm một lý do đằng sau cảm xúc phù hợp nhất với dữ liệu.

Và thứ tư, một khi robot đã xác định nguồn gốc của cảm xúc này, nó phải đưa ra phản ứng thích hợp. Điều này cũng khó khăn, vì thường có một số phản ứng có thể xảy ra, và một phản ứng sai có thể làm cho tình hình tồi tệ hơn. Robot đã có sẵn, trong chương trình của nó, một danh sách các phản ứng có thể có với cảm xúc ban đầu. Nó phải tính toán cái nào sẽ phục vụ tốt nhất cho tình huống, thứ có nghĩa là việc mô phỏng tương lai.

ROBOT SẼ NÓI DỐI?

Thông thường, chúng ta có thể nghĩ về robot là kẻ đầy lạnh lùng phân tích và lý trí, luôn luôn nói sự thật. Nhưng một khi robot trở nên hòa nhập với xã hội, có lẽ chúng sẽ phải học cách nói dối hoặc ít nhất là khéo léo kiềm chế ý kiến của mình.

Trong cuộc sống của chính chúng ta, nhiều lần trong một ngày điển hình chúng ta phải đối mặt với những tình huống mà chúng ta phải nói lời nói dối vô hại (white lie). Nếu mọi người hỏi rằng họ trông như thế nào, chúng ta thường không dám nói sự thật. Nói dối cách dễ thương, trên thực tế, giống như một loại dầu mỡ làm cho xã hội vận hành trơn tru. Nếu chúng ta bị buộc phải nói ra toàn bộ sự thật (như Jim Carrey trong Liar Liar), rất có thể chúng ta sẽ tạo ra sự hỗn loạn và làm tổn thương mọi người. Mọi người sẽ bị xúc phạm nếu bạn nói với họ những gì họ thực sự trông như thế nào hoặc bạn thực sự cảm thấy như thế nào. Các ông chủ sẽ sa thải bạn. Người yêu sẽ bỏ rơi bạn. Bạn bè sẽ xa lánh bạn. Người lạ sẽ tát bạn. Một số suy nghĩ tốt hơn là giữ bí mật.

Theo cách tương tự, robot có thể phải học cách nói dối hoặc che giấu sự thật, nếu không, chúng có thể gây khó chịu cho mọi người và bị chủ sở hữu của chúng thu lại quyền hay cắt phép. Trong một bữa tiệc, nếu một robot nói sự thật, nó có thể phản ánh không tốt về chủ nhân của nó và tạo ra sự náo động. Vì vậy, nếu ai đó hỏi ý kiến của robot, nó sẽ phải học cách lảng tránh, ngoại giao tính và khéo léo. Nó phải né tránh câu hỏi, thay đổi chủ đề, đưa ra các câu trả lời, trả lời bằng một câu hỏi hoặc nói lời dối dễ thương (tất cả những điều mà các chat-bot, trả lời tin nhắn hay thuật toán hội thoại tự động, ngày nay đang ngày càng giỏi). Điều này có nghĩa là robot đã được lập trình để có một danh sách các phản ứng lảng tránh có thể, và phải chọn một trong số đó tạo ra ít phiền phức nhất.

Một trong số ít lần robot sẽ nói toàn bộ sự thật là nếu được chủ sở hữu của nó hỏi một câu hỏi trực tiếp, người hiểu rằng câu trả lời có thể thật một cách tàn nhẫn. Có lẽ lần khác khi robot sẽ nói sự thật là khi có một cuộc điều tra của cảnh sát và sự thật tuyệt đối là cần thiết. Ngoài ra, robot sẽ có thể tự do nói dối hoặc che giấu toàn bộ sự thật để giữ cho những bánh xe của xã hội hoạt động.

Nói cách khác, robot phải được xã hội hóa, giống như thanh thiếu niên.

ROBOT CÓ CẢM THẤY ĐAU KHÔNG?

Robot, nói chung, sẽ được chỉ định để thực hiện các loại nhiệm vụ buồn tẻ, môi trường bẩn và nguy hiểm. Không có lý do tại sao robot không thể làm những công việc lặp đi lặp lại hoặc dơ bẩn cách vô thời hạn, vì chúng ta sẽ không lập trình cho chúng cảm thấy buồn chán hoặc ghê tởm. Vấn đề thực sự nổi lên khi robot phải đối mặt với những công việc nguy hiểm. Tại thời điểm đó, chúng ta thực sự có thể muốn lập trình cho chúng, robot cảm thấy đau.

Chúng ta đã tiến hóa cảm giác của sự đau đớn vì nó giúp chúng ta sống sót trong một môi trường nguy hiểm. Có một khiếm khuyết di truyền trong đó trẻ em được sinh ra mà không có khả năng cảm thấy đau đớn. Điều này được gọi là giảm đau bẩm sinh ongentinal analgesia. Thoạt nhìn, điều này có vẻ là một phước lành, vì những đứa trẻ này không khóc khi chúng bị thương, nhưng đó thực sự lại là một lời nguyền. Trẻ em mắc chứng bệnh này có vấn đề nghiêm trọng, chẳng hạn như cắn một phần lưỡi, bị bỏng da nghiêm trọng và tự cắt cơ thể, thường dẫn đến cắt cụt ngón tay. Nỗi đau đớn về cơ thể cảnh báo chúng ta về nguy hiểm, cho chúng ta biết khi nào cần di chuyển bàn tay ra khỏi bếp lò đang cháy hoặc ngừng chạy trên mắt cá chân bị trặc.

Tại một số thời điểm, robot được lập trình để cảm thấy đau đớn, nếu không chúng sẽ không biết khi nào nên tránh các tình huống bấp bênh. Cảm giác đau đầu tiên mà chúng phải có là đói (tức là thèm năng lượng điện). Khi pin của chúng hết, robots sẽ trở nên tuyệt vọng và cảm thấy khẩn cấp hơn, nhận ra rằng các mạch điện của chúng sẽ ngừng hoạt động, khiến mọi công việc của họ bị xáo trộn. Càng gần với việc chúng sắp hết pin hoặc cạn năng lượng, chúng sẽ càng trở nên lo lắng hơn.

Ngoài ra, bất kể chúng mạnh đến đâu, robot có thể vô tình nhặt được một vật quá nặng, có thể khiến tay chân chúng bị gãy. Hoặc chúng có thể bị quá nóng khi làm việc với kim loại nóng chảy trong nhà máy thép, hoặc bằng cách vào một tòa nhà đang cháy để giúp lính cứu hỏa. Các cảm biến về nhiệt độ và căng thẳng sẽ cảnh báo robots rằng các thông số kỹ thuật thiết kế của chúng đang bị vượt quá.

Nhưng một khi cảm giác đau đớn được (lập trình) thêm vào thực đơn hay danh mục cảm xúc của chúng, điều này ngay lập tức dấy lên các vấn đề đạo đức. Nhiều người tin rằng chúng ta không nên gây đau đớn không cần thiết cho động vật và mọi người cũng có thể cảm thấy như vậy về robot. Điều này mở ra cánh cửa cho quyền của robot. Luật pháp có thể phải được thông qua để hạn chế số lượng đau đớn và nguy hiểm mà robot được phép đối mặt. Mọi người sẽ không quan tâm nếu robot thực hiện các nhiệm vụ buồn tẻ hoặc bẩn thỉu, nhưng nếu họ cảm thấy đau (thực tế và tưởng tượng) khi thực hiện một nhiệm vụ nguy hiểm, họ có thể bắt đầu vận động luật pháp để bảo vệ robot. Điều này thậm chí có thể bắt đầu một cuộc xung đột pháp lý, với chủ sở hữu và nhà sản xuất robot tranh luận về việc tăng mức độ đau đớn mà robot có thể chịu đựng, trong khi các nhà đạo đức học có thể lập luận cho việc hạ thấp nó xuống (chỉ số chịu đựng sự đau đớn).

Điều này, đến lượt nó, có thể đặt ra các cuộc tranh luận đạo đức khác về các quyền robot khác. Robot có thể sở hữu tài sản? Điều gì xảy ra nếu chúng vô tình làm tổn thương ai đó? Chúng có thể bị kiện hay bị trừng phạt? Ai chịu trách nhiệm trong một vụ kiện? Robot có thể sở hữu một robot khác không? Cuộc thảo luận này đặt ra một câu hỏi khó khăn khác: Robot có nên được đưa vào chúng ý thức về đạo đức?

ROBOT ĐẠO ĐỨC

Lúc đầu, ý tưởng về robot đạo đức có vẻ như lãng phí thời gian và công sức. Tuy nhiên, câu hỏi này mang một ý nghĩa cấp bách khi chúng ta nhận ra rằng robot sẽ đưa ra quyết định sinh tử. Vì chúng sẽ mạnh mẽ về thể chất và có khả năng cứu sống nhiều sinh mạng, robots sẽ phải đưa ra những lựa chọn đạo đức trong giây lát về việc ai sẽ cứu trước.

Cứ cho rằng có một trận động đất thảm khốc và trẻ em bị mắc kẹt trong một tòa nhà đổ nát nhanh chóng. Robot nên phân bổ năng lượng như thế nào? Có nên cố gắng cứu số lượng trẻ em lớn nhất có thể? Hay là những đứa trẻ nhất? hay đứa dễ bị tổn thương nhất? Nếu các mảnh vỡ quá nặng, robot có thể làm hỏng thiết bị điện tử của nó. Vì vậy, robot phải quyết định một câu hỏi đạo đức khác: Làm thế nào để cân nhắc số lượng trẻ em nó cứu được so với mức độ thiệt hại, thứ mà nó sẽ cần để duy trì cho thiết bị điện tử của nó?

Nếu không có chương trình thích hợp, robot có thể đơn giản dừng lại, chờ đợi một con người đưa ra quyết định cuối cùng, (điều này thì) lãng phí thời gian quý giá. Vì vậy, ai đó sẽ phải lập trình trước đó để robot tự động đưa ra quyết định "đúng".

Những quyết định đạo đức này sẽ phải được lập trình sẵn vào máy tính ngay từ đầu, vì không có luật toán học nào có thể đặt hay đưa ra giá trị cụ thể bằng con số cho việc cứu một nhóm trẻ em. Trong chương trình của nó, phải có một danh sách dài các thứ, được xếp hạng về tầm quan trọng của chúng. Đây là công việc rất tẻ nhạt. Trên thực tế, đôi khi con người phải mất cả đời để học những bài học đạo đức này, nhưng một robot đã và đang học chúng rất nhanh, trước khi nó rời khỏi nhà máy, nếu nó được đưa vào xã hội một cách an toàn.

Chỉ có mọi người có thể làm điều này, và thậm chí sau đó những tình huống khó xử về đạo đức đôi khi làm chúng ta bối rối. Nhưng điều này đặt ra câu hỏi: Ai sẽ đưa ra quyết định? Ai quyết định thứ tự trong việc robot cứu mạng con người?

Câu hỏi về cách các quyết định cuối cùng sẽ được đưa ra có thể sẽ được giải quyết thông qua sự kết hợp của luật pháp và thị trường. Luật pháp sẽ phải được thông qua để có tối thiểu một bảng xếp hạng về tầm quan trọng của những người cần cứu trong trường hợp khẩn cấp. Nhưng ngoài ra, có hàng ngàn câu hỏi đạo đức tốt hơn. Những quyết định tinh tế hay khôn khéo hơn có thể được quyết định bởi thị trường và lẽ thường.

Nếu bạn làm việc cho một công ty an ninh bảo vệ những người quan trọng, bạn sẽ phải nói với robot cách cứu người theo thứ tự chính xác trong các tình huống khác nhau, không những chỉ dựa trên những cân nhắc như hoàn thành nhiệm vụ chính mà còn thực hiện nó trong ngân sách được cho phép.

Điều gì xảy ra nếu một tên tội phạm mua robot và muốn robot phạm tội? Điều này đặt ra một câu hỏi: Robot có nên được phép thách thức chủ sở hữu của nó nếu nó được yêu cầu vi phạm pháp luật? Chúng ta đã thấy từ ví dụ trước rằng robot phải được lập trình để hiểu luật và cũng đưa ra quyết định đạo đức. Vì vậy, nếu nó quyết định rằng nó đang được yêu cầu vi phạm pháp luật, nó phải được phép không tuân theo chủ của nó.

Ngoài ra còn có tình trạng khó xử về đạo đức được đặt ra bởi các robot phản ánh niềm tin của chủ sở hữu của chúng, những người chủ này có thể có sự khác biệt về đạo đức và các chuẩn mực xã hội. "Cuộc chiến văn hóa" mà chúng ta thấy trong xã hội ngày nay sẽ chỉ được phóng đại khi chúng ta có những robot phản ánh ý kiến và niềm tin của chủ nhân chúng. Ở một khía cạnh nào đó, cuộc xung đột này là không thể tránh khỏi. Robot là phần mở rộng cơ học của những giấc mơ và mong muốn của người tạo ra chúng, và khi robot đủ tinh vi để đưa ra quyết định đạo đức, chúng sẽ làm như vậy.

Các khu vực hay đường lỗi của xã hội có thể bị căng thẳng khi robot bắt đầu thể hiện những hành vi thách thức các giá trị và mục tiêu của chúng ta. Robots thuộc sở hữu của thanh niên để lại một buổi hòa nhạc rock ồn ào, khàn khàn có thể xung đột với robot thuộc sở hữu của cư dân cao tuổi của một khu phố yên tĩnh. Bộ robot đầu tiên có thể được lập trình để khuếch đại âm thanh của các dải mới nhất, trong khi bộ thứ hai có thể được lập trình để giữ mức độ ồn ở mức tối thiểu. Robots thuộc sở hữu của những người sùng đạo, những người theo trào lưu chính thống (churchgoing fundamentalists) có thể tranh luận với những robot thuộc sở hữu của những người vô thần (atheists). Robots từ các quốc gia và nền văn hóa khác nhau có thể được thiết kế để phản ánh các hoạt động xã hội của họ, có thể va chạm hay đụng độ (ngay cả đối với con người, nói gì đến robot).

Vậy làm thế nào để một robot (được) lập trình để loại bỏ những xung đột này?

Bạn không thể. Robot sẽ chỉ đơn giản phản ánh những thiên kiến (biases) và thành kiến (prejudices) của người tạo ra chúng. Cuối cùng, sự khác biệt về văn hóa và đạo đức giữa những robot này sẽ phải được giải quyết tại tòa án. Không có định luật vật lý hay khoa học nào quyết định những câu hỏi đạo đức này, vì vậy cuối cùng luật sẽ phải được viết để xử lý những xung đột xã hội này. Robot không thể giải quyết những tình huống khó xử về đạo đức do con người tạo ra. Trong thực tế, robot có thể khuếch đại chúng lên.

Nhưng nếu như robot có thể đưa ra quyết định đạo đức và pháp lý, chúng cũng có thể cảm nhận và hiểu cảm giác? Nếu robots thành công trong việc cứu ai đó, chúng có thể trải nghiệm niềm vui (cho điều ấy) không? Hay thậm chí chúng có thể cảm thấy những thứ như màu đỏ? Lạnh lùng phân tích đạo đức của ai để cứu là một chuyện, nhưng hiểu và cảm nhận/feeling thì lại là chuyện khác. Vì vậy, robot có thể cảm thấy/feel không?

ROBOT CÓ THỂ HIỂU HAY CẢM NHẬN?

Trong nhiều thế kỷ, rất nhiều lý thuyết đã được đưa ra về việc một cỗ máy có thể suy nghĩ và cảm nhận hay không. Triết lý của riêng tôi được gọi là "Constructivism, hiểu là chủ nghĩa kiến tạo"; nghĩa là, thay vì vô tận đặt câu hỏi, điều này là vô nghĩa, chúng ta nên dành năng lượng của mình để tạo ra một máy tự động giống con người, automaton, để xem chúng ta có thể đi được bao xa. Nếu không, chúng ta kết thúc trong các cuộc tranh luận triết học bất tận, là thứ mà cuối cùng không bao giờ được giải quyết. Ưu điểm của khoa học là, một khi mọi thứ được nói và làm, người ta có thể thực hiện các thí nghiệm để giải quyết một câu hỏi một cách quyết đoán.

Do đó, để giải quyết câu hỏi liệu robot có thể suy nghĩ hay không, giải pháp cuối cùng có thể là chế tạo ra một thành phẩm. Tuy nhiên, một số người đã lập luận rằng máy móc sẽ không bao giờ có thể nghĩ như con người. Lập luận mạnh mẽ nhất của họ là, mặc dù robot có thể thao tác hay vận dụng sự kiện nhanh hơn con người, nhưng nó không "hiểu" những gì nó đang vận dụng. Mặc dù nó có thể xử lý các giác quan (ví dụ: màu sắc, âm thanh) tốt hơn con người, nhưng nó không thể thực sự "cảm nhận" hay "trải nghiệm" bản chất của các giác quan hay những ý nghĩa này.

Chẳng hạn, triết gia David Chalmers (giám đốc trung tâm nhận thức đại học quốc gia Úc, nghiên cứu về triết học tinh thần và ý thức) đã chia các vấn đề của AI thành hai loại, Vấn Đề Dễ và Vấn Đề Khó. Đối với ông, [Vấn Đề Dễ] là việc đang tạo ra những cỗ máy có thể bắt chước ngày càng nhiều khả năng của con người, như chơi cờ, thêm số, nhận biết một số mẫu nhất định, v.v. [Vấn Đề Khó] liên quan đến việc tạo ra các máy có thể hiểu cảm nhận và cảm giác chủ quan, được gọi là Qualia.(Qualia: Những thành phần thuộc về bên trong và chủ thể của nhận thức ý nghĩa, phát sinh từ sự kích thích các giác quan bởi các hiện tượng. Hay cụ thể ý ở đây là: vấn đề Khách Thể Object và Chủ Thể Subject)

Cũng giống như không thể dạy ý nghĩa của màu đỏ cho người mù, robot sẽ không bao giờ có thể trải nghiệm cảm giác chủ quan của màu đỏ, họ nói. Hoặc một máy tính có thể có khả năng dịch các từ tiếng Trung sang tiếng Anh rất trôi chảy, nhưng nó sẽ không bao giờ có thể hiểu những gì nó đang dịch. Trong bức tranh này, robot giống như máy ghi băng được tôn vinh hoặc máy tính cộng trừ nhân chia (adding machines), có thể đọc và xử lý thông tin với độ chính xác đáng kinh ngạc nhưng không có bất kỳ hiểu biết nào.

Những lập luận này phải được thực hiện nghiêm túc, nhưng cũng có một cách khác để xem xét câu hỏi về phẩm chất (qualia) và kinh nghiệm thuộc về chủ quan. Trong tương lai, một chiếc máy rất có thể sẽ có thể xử lý một cảm giác, chẳng hạn như màu đỏ, tốt hơn nhiều so với bất kỳ con người nào. Nó sẽ có thể mô tả các tính chất vật lý của màu đỏ và thậm chí sử dụng nó một cách thi vị trong một câu văn tốt hơn một con người. Robot có "cảm nhận" màu đỏ không? Điểm này trở ra chẳng hiểu nổi hay không liên quan gì sất, vì từ "cảm thấy" không được định nghĩa rõ. Tại một số điểm, mô tả của robot về màu đỏ có thể vượt quá mô tả của con người và robot có thể hỏi cách chính xác: Con người có thực sự hiểu màu đỏ không? Có lẽ con người không thể thực sự hiểu màu đỏ với tất cả các sắc thái và tinh tế mà robot có thể.

Như nhà hành vi B. F. Skinner (1904 – 1990) từng nói: "Vấn đề thực sự không phải là máy móc có suy nghĩ hay không, mà là con người có làm điều ấy chứ. The real problem is not whether machines think, but whether men do".

Tương tự như vậy, vấn đề chỉ là thời gian trước khi robot có thể định nghĩa các từ tiếng Trung và sử dụng chúng trong ngữ cảnh tốt hơn bất kỳ con người nào. Vào thời điểm đó, việc robot "hiểu" tiếng Trung Quốc trở nên không liên quan gì cả, hay tạm hiểu là việc ấy dường như vô nghĩa về mặt tương tác. Đối với tất cả các mục đích thực tế, máy tính sẽ biết tiếng Trung Quốc hơn bất kỳ con người nào. Nói cách khác, từ "hiểu/understand" không được xác định rõ ràng.

Một ngày nào đó, khi robot vượt qua khả năng của chúng ta để thao tác những từ ngữ và cảm giác này, nó sẽ trở nên không liên quan cho dù robot "hiểu" hay "cảm nhận" chúng. Câu hỏi kia sẽ không còn quan trọng.

Như nhà toán học John von Neumann đã nói, "Trong toán học, bạn không hiểu các thứ. Bạn chỉ cần làm quen với chúng."

Vì vậy, vấn đề không nằm ở phần cứng mà ở bản chất ngôn ngữ của con người, trong đó những từ/chữ/words không được xác định rõ ý nghĩa (mean) sẽ trở ra là những thứ khác nhau đối với những người khác nhau. Nhà vật lý lượng tử vĩ đại Niels Bohr đã từng được hỏi làm thế nào người ta có thể hiểu được những nghịch lý sâu sắc của lý thuyết lượng tử. Câu trả lời ông đưa ra là, nó nằm ở cách bạn định nghĩa từ "hiểu".

Tiến sĩ Daniel Dennett, một triết gia tại Đại học Tufts, đã viết, "Không thể có một bài kiểm tra khách quan để phân biệt một robot thông minh với một người có ý thức. Bây giờ bạn có một lựa chọn: bạn có thể hoặc là bám vào Vấn Đề Khó/Hard Problem, hoặc bạn có thể lắc đầu ngạc nhiên và gạt bỏ nó. Hãy buông tay."

Nói cách khác, không có thứ gì gọi là [Vấn Đề Khó] cả.

Đối với triết lý kiến tạo, vấn đề không phải là tranh luận liệu một cỗ máy có thể trải nghiệm màu đỏ hay không, mà là để xây dựng cỗ máy ấy. Trong bức tranh này, có một mức độ liên tục (continuum) mô tả các từ "hiểu" và "cảm nhận". (Điều này có nghĩa là thậm chí có thể đưa ra các giá trị thuộc về con số cho mức độ hiểu và cảm nhận). Cuối cùng ở đầu bên này, chúng ta có những con robot vụng về ngày nay, thứ có thể điều khiển một vài biểu tượng nhưng không nhiều hơn thế. Ở đầu mút bên kia, chúng ta có con người, những người tự hào về cảm giác phẩm chất bên trong qualia. Nhưng khi thời gian trôi qua, robot cuối cùng sẽ có thể cảm nhận tuyệt vời hơn chúng ta ở bất kỳ cấp độ nào. Sau đó, rõ ràng là robot sẽ hiểu.

Đây là triết lý đằng sau bài kiểm tra Turing nổi tiếng của Alan Turing. Ông dự đoán rằng một ngày nào đó một chiếc máy sẽ được chế tạo có thể trả lời bất kỳ câu hỏi nào, để nó không thể phân biệt được với con người. Ông nói, "Một máy tính sẽ xứng đáng được gọi là thông minh nếu nó có thể đánh lừa một con người tin rằng đó là con người."

Nhà vật lý và người đoạt giải Nobel, ông Francis Crick, nói về điều đó tốt nhất. Trong thế kỷ trước, ông lưu ý, các nhà sinh học đã tranh luận sôi nổi về câu hỏi "What is life, Sự sống là gì?" Bây giờ, với sự hiểu biết của chúng ta về DNA, các nhà khoa học nhận ra rằng câu hỏi không được xác định rõ. Có rất nhiều biến thể, lớp lang và sự phức tạp cho câu hỏi đơn giản đó. Câu hỏi "Cuộc sống là gì?" Đơn giản là biến chất dần đi. Điều tương tự cuối cùng có thể áp dụng cho cái gọi là cảm giác và sự hiểu biết.

TƯƠNG LAI CỦA TÂM TRÍ - MICHIO KAKU

BẢN DỊCH CỦA ĐỖ BÁ HUY