Những tiến bộ về trí tuệ nhân tạo có thể dẫn tới sự gia tăng quy mô lớn về sử dụng năng lượng. Bài của Michael Le Page đăng trên tạp chí New Scientist (13/10/2018).

Những đột phá về trí tuệ nhân tạo (AI – Artificial Intelligence) đã xuất hiện đều đặn trong những năm gần đây. Một trong những thành tựu ấn tượng nhất từ trước đến nay là vào năm 2016 khi AI Alpha Go của Google DeepMind đánh bại nhà vô địch Lee Sedol ở môn thể thao trí tuệ phức tạp nhất thế giới: Cờ vây.

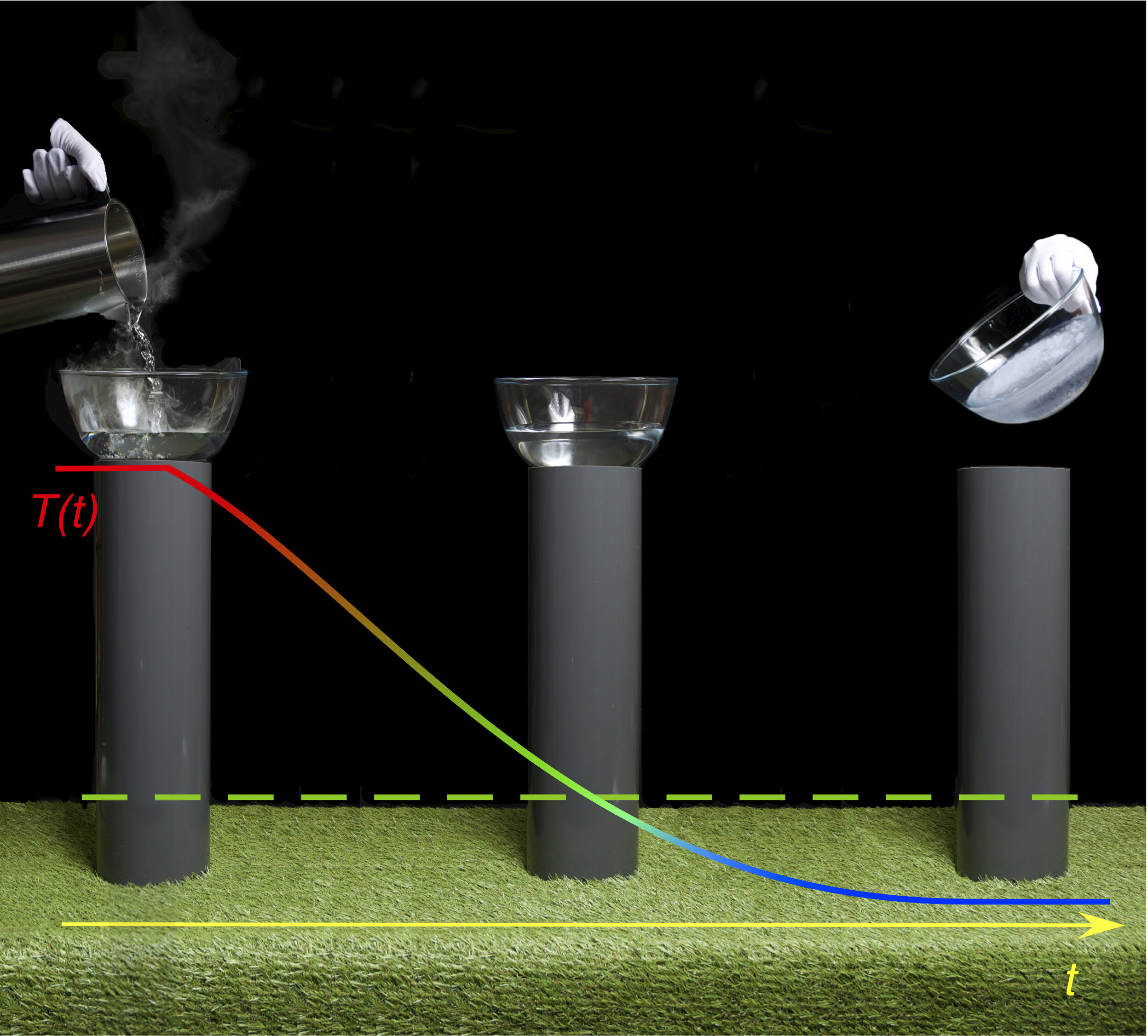

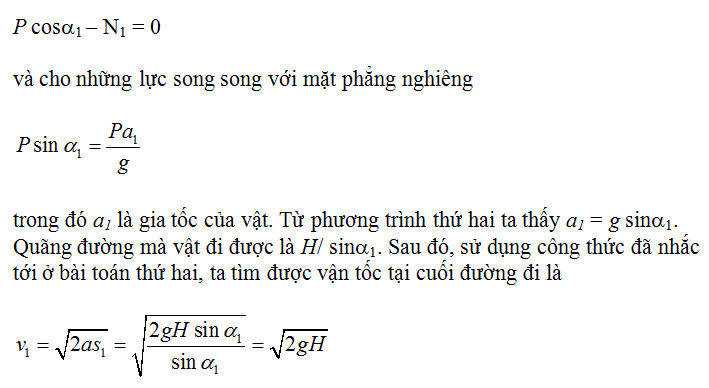

Thành tựu ấy gây đình đám khắp thế giới rằng máy móc đánh bại con người, nhưng hiểu theo một nghĩa nào đó thì đây không phải một trận đấu công bằng. Bộ não Sedol tiêu thụ công suất khoảng chừng 20 watt, và chỉ một phần nhỏ trong số đó dùng để chơi cờ. Trái lại, AlphaGo xài công suất đến 5.000 watt.

Ít người đánh giá đúng AI đói khát năng lượng khủng khiếp như thế nào. Nếu bạn chạy AlphaGo liên tục không nghỉ trong một năm, thì điện năng tiêu thụ sẽ ngốn khoảng 6.000 bảng Anh. Con số đó không thành vấn đề đối với các sự kiện hi hữu, kiểu như một màn trình diễn Cờ vây đi vào lịch sử. Nhưng nó sẽ thành vấn đề nếu hàng tỉ người muốn điện thoại thông minh của họ thật sự thông minh, hoặc có xe hơi của họ tự lái.

Nhiều công dụng tiềm năng của AI sẽ không được sử dụng rộng rãi nếu chúng đòi hỏi quá nhiều năng lượng. Thế nhưng, nếu các công dụng ấy là đáng khao khát hoặc sinh lợi nhuận thì người ta chẳng quan tâm về chi phí, và nó sẽ dẫn tới dấy lên một làn sóng tiêu thụ năng lượng và sẽ khiến việc kiểm soát sự ấm lên toàn cầu trở nên khó khăn hơn.

AI tiêu thụ nhiều năng lượng như thế bởi vì kĩ thuật ẩn sau những đột phá trong thời gian gần đây này, deep learning (học sâu), liên quan đến việc thực hiện ngày càng nhiều phép điện toán hơn trên dữ liệu ngày càng đồ sộ hơn. “Các mô hình đang tiến sâu hơn và tiến rộng hơn, và chúng sử dụng càng nhiều năng lượng hơn để tính toán,” phát biểu của Max Welling tại Đại học Armsterdam, Hà Lan.

Lấy ví dụ như việc nhận diện ảnh. Điều này được thực hiện bằng cách huấn luyện một mạng lưới giả-thần kinh bắt chước bộ não. Hình ảnh được chia nhỏ và cho vào lớp thứ nhất của mạng lưới, lớp này có thể tìm kiếm các đường bao. Các kết quả được cho qua lớp tiếp theo, nó có thể tìm kiếm những hình dạng đơn giản như cái đuôi chó hay một chữ cái, và cứ thế.

Bạn muốn mạng lưới nhận diện càng nhiều chi tiết, thì nó phải có càng nhiều lớp và nó càng phức tạp. Nhận diện các bộ phận khác nhau của con chó, chẳng hạn, là nhiệm vụ khó khăn hơn nhiều so với nhận diện chỉ con chó thôi.

Các mạng lưới giả-thần kinh phức tạp nhất đã phát triển đến mức “lớn thái quá”, như một bài báo mới đây gọi thế. Mức phức tạp của chúng có thể được đo bằng số lượng tham số trong mạng lưới, và một số mạng lưới hiện nay có hơn 100 tỉ tham số.

Điều này quan trọng vì hai lí do, Welling cho biết. Thứ nhất, năng lượng là tiền bạc. “Có một mức trần kinh tế đối với mỗi công nghệ AI hữu ích,” ông nói. Đối với các dịch vụ mạng đồ sộ như Facebook và Google, chi phí trên mỗi lượt dùng AI là rất nhỏ - chưa tới một phần nghìn của một đồng penny.

Thứ hai, các thiết bị di động chỉ có thể sử dụng năng lượng ứng với một mức nào đó thôi. Không chỉ vấn đề tuổi thọ pin, mà còn phải đảm bảo các thiết bị không quá nóng nữa, Welling cho biết.

Đây là lí do vì sao các trợ lí giọng nói như Siri hay Alexa cần một kết nối Internet để hoạt động đủ chức năng – điện thoại hoặc chiếc loa thông minh của bạn không có đủ công suất xử lí cần thiết để chạy AI trên nền cục bộ, hoặc không gian để lưu trữ mọi dữ liệu đi cùng.

Toàn bộ điều này có nghĩa là việc chúng ta sử dụng AI không thể cứ tiếp tục mở rộng hoài trừ khi chúng ta giảm được mức năng lượng đòi hỏi. “Vấn đề là chúng ta có thể gói ghém được bao nhiêu trí thông minh trên mỗi joule,” Welling nói.

Xét xe tự lái. Các xe này đòi hỏi đủ thứ hệ thống gắn thêm, từ camera đến radar, chúng vừa sử dụng năng lượng vừa làm tăng trọng lượng và lực kéo theo, thành ra làm tăng thêm năng lượng sử dụng. Song bộ phận ngốn nhiều năng lượng nhất bên cạnh động cơ là bộ xử lí chạy AI.

Theo một nghiên cứu hồi đầu năm nay, xe tự lái có thể dùng nhiều năng lượng hơn đến 20% so với xe truyền thống. Đó là một vấn đề lớn cho xe chạy pin, làm hạn chế tầm hoạt động của nó và làm tăng chi phí hoạt động. Ngoài ra, nghiên cứu ấy còn giả sử bộ xử lí AI ngốn khoảng 200 watt, mặc dù các nguyên mẫu hiện nay ngốn trên 2000 watt.

Đối với các hãng taxi sử dụng AI thế chỗ các tài xế, khoản tiết kiệm từ tiền lương sẽ có khả năng bù dư cho chi phí năng lượng đội lên thêm. Song đối với các chủ xe bình thường, thì đây hẳn là một vấn đề không nhỏ.

May thay, người ta đã sẵn sàng cải tiến hiệu suất của các thuật toán học sâu, chẳng hạn bằng cách tước đi độ chính xác không cần thiết trong các phép tính làm tăng đáng kể mức xử lí cần thiết.

“Dù bạn sử dụng ít bit hơn đi nữa, bạn vẫn có thể huấn luyện mạng lưới giả-thần kinh cho các kết quả giống như vậy,” phát biểu của Avishek Biswas tại Viện Công nghệ Massachusetts.

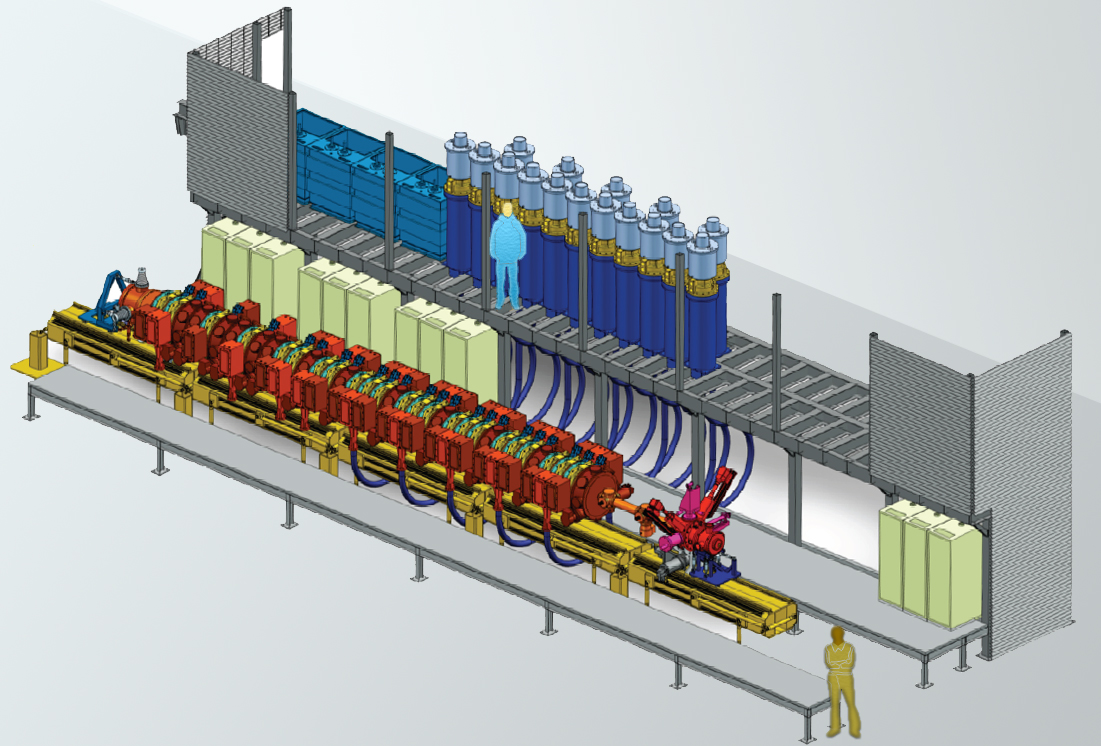

Nhiều hãng công nghệ lớn cũng đang phát triển phần cứng chuyên để chạy AI. Nvidia, chẳng hạn, đã chế tạo một con chip dành riêng cho xe tự lái – mặc dù phiên bản mới nhất vẫn dùng đến 500 watt.

Trong khi đó, Google đã chế tạo cái họ gọi là đơn vị xử lí tensor, hay TPU, nó được thiết kế để chạy bộ sườn học máy TensorFlow của hãng, và hiện đang cho thuê chúng qua dịch vụ đám mây.

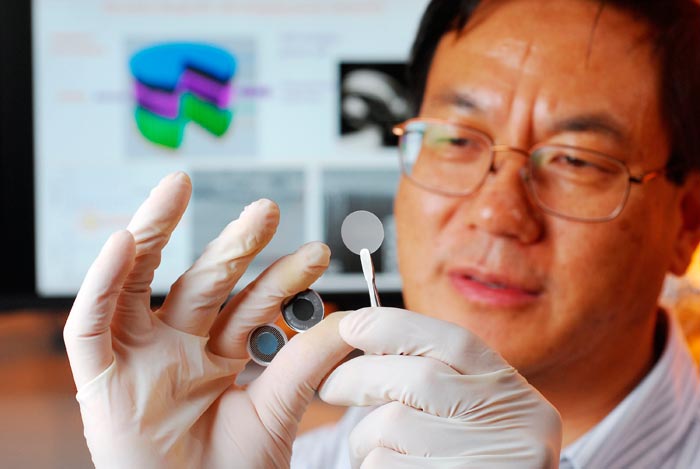

Còn có những thiết kế mang tính cách mạng hơn nhiều vẫn đang được nghiên cứu. Dữ liệu chạy tới chạy lui giữa bộ nhớ và bộ vi xử lí làm lãng phí rất nhiều năng lượng, theo lời Biswas. Vì thế ông đã phát triển một con chip dành cho điện thoại thông minh làm giảm mức sử dụng năng lượng đi khoảng 95% bằng cách thực hiện các phép tính chủ yếu trong chính bộ nhớ.

Tốc độ tiến bộ thật đáng kinh ngạc. Phiên bản mới nhất của AlphaGo, gọi là AlphaGo Zero, chạy trên đúng bốn TPU, và tiêu hao khoảng 400 watt.

Song liệu những con chip mới này có thật sự làm giảm mức sử dụng năng lượng chung của AI hay không? Khi AI trở nên hiệu quả năng lượng hơn, chúng ta sẽ xây dựng những hệ thống tốt hơn và dùng nó làm nhiều việc hơn, nghĩa là có thể một lần nữa chẳng có cắt giảm năng lượng gì hết. “Chắc chắn việc sử dụng năng lượng sẽ tiếp tục tăng lên với AI cứ phức tạp dần,” Welling nói.

Thật vậy, AI sắp giữ một vai trò chính trong nền kinh tế thế giới. Theo công ti nghiên cứu thị trường IDC, chi tiêu toàn cầu cho các hệ thống AI theo dự báo sẽ đạt tới 60 tỉ đôla vào năm 2021. Trong khi đó, một công ti nghiên cứu khác, Garnert, dự báo thị trường kinh doanh gốc AI sẽ đạt tới bốn nghìn tỉ đôla vào năm 2022.

Thế nhưng chúng ta chẳng biết điều này có ý nghĩa gì đối với việc sử dụng năng lượng toàn cầu. Theo ước tính, việc điện toán và Internet tiêu thụ khoảng 5% lượng điện năng toàn cầu, và AI hiện nay rõ ràng chỉ mới chiếm một phần nhỏ trong số này.

“Chẳng ai biết gì nhiều về nó ở giai đoạn này,” phát biểu của Anders Andrae thuộc hãng Huawei Technologies, người đã nghiên cứu mức tiêu thụ năng lượng của công nghệ thông tin. “Song sẽ rất nguy hiểm nếu nói chuyện này chẳng có gì đáng quan tâm.”

Đó là vì vấn đề không phải chỉ là bản thân AI tiêu hao bao nhiêu năng lượng, mà còn các hiệu ứng dây chuyền khác nữa. Trở lại với ví dụ xe tự lái, trên lí thuyết chúng có thể hoạt động theo một cách làm giảm mức tiêu hao năng lượng tổng thể bất chấp các yêu cầu năng lượng cao hơn của chúng. Chẳng hạn, chúng có thể sắp hàng nối đuôi nhau để giảm lực kéo theo và giao tiếp với nhau để chúng không cần dừng lại tại các giao lộ.

Nhưng phần lớn những tiết kiệm này đòi hỏi một tỉ lệ lớn xe chạy trên đường phải là tự động hóa – y hệt như một mạng xã hội như Facebook chỉ có thể nhộn nhịp thật sự khi nó đạt tới một lượng người dùng nhất định. “Các hiệu ứng phụ thuộc mạng sẽ không xảy ra trong những giai đoạn đầu,” phát biểu của Zia Wadud tại Đại học Leeds, Anh, người chuyên nghiên cứu giao thông và năng lượng.

Con người với xe tự lái sẽ có khả năng đi lại đều đặn trên những quãng đường xa hơn, vì họ không phải tập trung vào đường xá và có thể sử dụng thời gian để lướt Internet hoặc xem video. Wadud cho rằng tiến bộ này có thể làm tăng gấp đôi mức sử dụng năng lượng – và nghiên cứu của ông chưa tính đến phần AI, hay sự gia tăng hàng loạt lưu lượng dữ liệu mà những chiếc xe này sẽ tạo ra.

Trong những năm gần đây, nhu cầu điện năng vẫn bình ổn bất chấp sự tăng vọt lưu lượng Internet, đó là nhờ những cải thiện to lớn về hiệu suất. Nhưng Andrae cho rằng chúng ta đã đạt tới giới hạn của sự cải thiện hiệu suất theo cách đơn giản.

Nếu lượng dữ liệu chúng ta tạo ra cứ tiếp tục tăng mà không có sự cải thiện lớn về hiệu suất, thì mức năng lượng dành cho công nghệ thông tin và truyền thông có thể tăng vọt đến 20% tổng lượng điện năng vào năm 2025 và chiếm một phần hai mươi tổng lượng phát thải carbon toàn cầu, theo Andrae. “Đây có thể sẽ là một vấn đề rất khủng,” ông nói.

Chi phí cao khiến kịch bản trường hợp xấu nhất không có khả năng xảy ra. Nhưng công trình của Andrae chưa tính đến AI và có thể đã đánh giá thấp sự tăng trưởng dữ liệu, chẳng hạn dữ liệu từ rất nhiều xe AI giao tiếp với nhau.

“Tôi nghĩ AI sẽ tạo ra nhiều dữ liệu hơn chúng ta từng thấy,” ông nói. “Nếu nhiều dữ liệu hơn đồng nghĩa với tiền bạc, thì họ sẽ sử dụng trí tuệ nhân tạo để có thêm nhiều dữ liệu hơn, và nhiều dữ liệu hơn nghĩa là dùng nhiều điện năng hơn.” Và chừng nào các hệ thống điện của chúng ta vẫn chưa 100% năng lượng tái sinh, thì nhiều điện năng hơn nghĩa là sự ấm lên toàn cầu.

Nguồn: New Scientist

![[ebook] Thiên Văn Vật Lí Cho Người Bận Rộn](/bai-viet/images/2019/05/thienvan2.png)